Các lãnh đạo an ninh và Giám đốc An ninh Thông tin (CISO) đang nhận thấy một loạt ứng dụng AI không được phê duyệt, gọi là shadow AI, đã và đang xâm nhập mạng lưới của họ, đôi khi diễn ra trong hơn một năm.

Đây không phải là thủ đoạn của tin tặc điển hình. Chúng xuất phát từ việc nhân viên đáng tin cậy tạo ra ứng dụng AI mà không được phòng CNTT và an ninh giám sát hay phê duyệt, thường nhằm mục đích tự động hóa báo cáo (trước đây phải làm thủ công) hoặc sử dụng AI tạo sinh (genAI) để tinh giản quy trình tiếp thị, trực quan hóa và phân tích dữ liệu nâng cao. Chúng được cung cấp dữ liệu độc quyền của công ty, khiến mô hình nguồn mở (public domain) được huấn luyện bằng dữ liệu nội bộ.

Shadow AI là gì, và vì sao nó đang lan nhanh

Những ứng dụng và công cụ AI được phát triển theo cách này hiếm khi có rào chắn an ninh. Shadow AI mang đến rủi ro lớn, trong đó có khả năng rò rỉ dữ liệu, vi phạm tuân thủ và tổn hại uy tín.

Nó như “chất kích thích kỹ thuật số” cho phép người dùng hoàn thành công việc chi tiết trong thời gian ngắn hơn, thường vượt tiến độ. Có những phòng ban tận dụng shadow AI để nâng năng suất, ít tốn thời gian hơn. “Tôi chứng kiến điều này hằng tuần,” Vineet Arora, Giám đốc Công nghệ (CTO) tại WinWire, chia sẻ với VentureBeat gần đây. “Nhiều nhóm nhảy vào giải pháp AI tự phát vì lợi ích trước mắt quá hấp dẫn.”

“Chúng tôi thấy 50 ứng dụng AI mới mỗi ngày, đã ghi nhận hơn 12000 ứng dụng,” Itamar Golan, CEO kiêm đồng sáng lập Prompt Security, nói với VentureBeat. “Khoảng 40% số đó mặc định huấn luyện trên mọi dữ liệu mà bạn nạp vào, đồng nghĩa với việc tài sản trí tuệ của bạn có thể trở thành một phần mô hình.”

Phần lớn nhân viên tạo ứng dụng shadow AI không hề có ý xấu hay muốn gây hại cho công ty. Họ đang đối mặt với khối lượng công việc phức tạp tăng nhanh, tình trạng thiếu thời gian mạn tính và hạn chót ngày càng gắt gao.

Golan ví von: “Nó giống như doping ở giải đua xe đạp Tour de France. Họ muốn có lợi thế mà không lường được hậu quả lâu dài.”

Một đợt sóng ngầm không ai ngờ tới

“Bạn không thể chặn sóng thần, nhưng có thể đóng tàu,” Golan chia sẻ với VentureBeat. “Giả vờ như AI không tồn tại chẳng thể bảo vệ bạn, mà chỉ khiến bạn bị đòn bất ngờ.” Golan lấy ví dụ về một lãnh đạo an ninh tại một công ty tài chính ở New York tin rằng có dưới 10 công cụ AI đang được dùng. Kiểm toán 10 ngày phát hiện 65 giải pháp chưa được duyệt, đa số không có giấy phép chính thức.

Arora đồng ý: “Dữ liệu cho thấy, khi nhân viên có lối đi AI được phê duyệt và chính sách rõ ràng, họ không còn động cơ dùng công cụ lung tung trong âm thầm. Điều đó giảm rủi ro và xung đột.” Arora và Golan nhấn mạnh với VentureBeat về tốc độ tăng nhanh của số ứng dụng AI không được duyệt mà họ phát hiện ở công ty khách hàng.

Kết quả từ một khảo sát của Software AG cũng ủng hộ quan điểm này. Có tới 75% nhân viên tri thức (knowledge workers) đã sử dụng công cụ AI, 46% nói họ sẽ không bỏ, dù công ty cấm. Phần lớn ứng dụng shadow AI vận hành trên ChatGPT của OpenAI và Google Gemini.

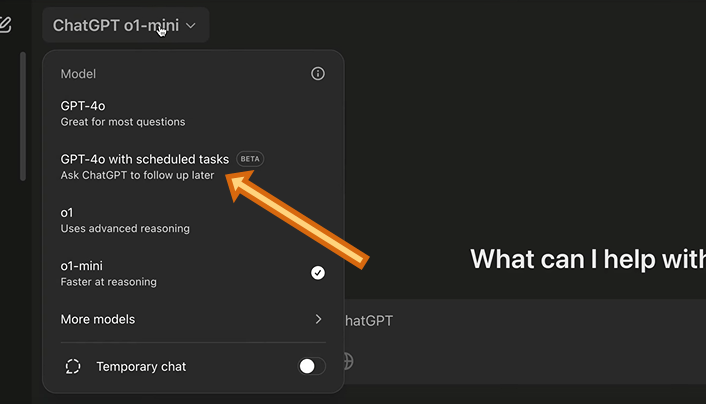

Từ năm 2023, ChatGPT cho phép tạo chatbot tùy biến chỉ trong vài phút. VentureBeat ghi nhận rằng một nhà quản lý (phụ trách bán hàng, thị trường, dự báo giá) trung bình có 22 chatbot tùy biến trong ChatGPT.

Không khó hiểu vì sao shadow AI lan rộng khi 73,8% tài khoản ChatGPT không phải tài khoản doanh nghiệp, không có kiểm soát về bảo mật và quyền riêng tư như các giải pháp được bảo vệ hơn. Tỷ lệ đó ở Gemini còn cao hơn (94,4%). Một khảo sát của Salesforce cho thấy hơn một nửa (55%) nhân viên toàn cầu thừa nhận đang dùng công cụ AI không được duyệt tại nơi làm việc.

“Nó không phải cú nhảy một lần có thể vá,” Golan nói tiếp. “Đó là một đợt sóng tính năng AI do nhà cung cấp tung ra mà không có giám sát của IT.” Hàng nghìn tính năng AI nhúng trong sản phẩm SaaS phổ biến đang bị sửa đổi để huấn luyện, lưu trữ, rò rỉ dữ liệu doanh nghiệp, mà không ai ở IT hay an ninh biết.

Shadow AI từ từ tháo rời vành đai an ninh doanh nghiệp. Nhiều người không thấy vì họ mù mờ trước làn sóng shadow AI.

Vì sao shadow AI nguy hiểm

“Nếu bạn dán mã nguồn hay dữ liệu tài chính vào, nó sẽ sống trong mô hình đó,” Golan cảnh báo. Arora và Golan tìm thấy nhiều công ty đang huấn luyện mô hình công khai, mặc định dùng ứng dụng shadow AI cho rất nhiều tác vụ phức tạp.

Khi dữ liệu độc quyền đã lọt vào mô hình công cộng, thử thách tiếp theo sẽ bám theo mọi tổ chức. Đặc biệt phức tạp với công ty đại chúng thường có yêu cầu tuân thủ và quy định khắt khe. Golan dẫn chứng Đạo luật AI của EU sắp ra đời “thậm chí có thể vượt mức GDPR về mức phạt,” đồng thời cảnh báo rằng lĩnh vực có quy định ở Mỹ cũng rủi ro bị phạt nếu dữ liệu riêng tư rò rỉ vào công cụ AI chưa được duyệt.

Ngoài ra còn có nguy cơ lỗ hổng khi chạy, tấn công “prompt injection,” thứ mà hệ thống bảo mật đầu cuối hay nền tảng ngăn thất thoát dữ liệu (DLP) truyền thống không thể phát hiện và ngăn chặn.

Kế hoạch toàn diện của Arora để quản lý an toàn và thúc đẩy sáng tạo

Arora thấy cả đơn vị kinh doanh dùng công cụ AI SaaS mà không báo cáo, do họ có quyền chủ động chi tiêu cho nhiều nhóm công việc và triển khai AI nhanh chóng, thường không có xác nhận an ninh.

“Đột nhiên, bạn có hàng chục ứng dụng AI ít người biết đến, xử lý dữ liệu doanh nghiệp mà không qua một quy trình tuân thủ hay đánh giá rủi ro,” Arora chia sẻ với VentureBeat.

Các điểm chính từ kế hoạch của Arora:

- Shadow AI phát triển vì các khung IT và an ninh hiện tại không phát hiện được. Arora nhận định hạ tầng IT truyền thống thiếu khả năng quan sát và quản lý cần thiết để đảm bảo an toàn. “Phần lớn công cụ và quy trình quản lý IT hiện tại thiếu tầm nhìn và kiểm soát toàn diện với ứng dụng AI.”

- Mục tiêu: kích hoạt đổi mới mà vẫn duy trì kiểm soát. Arora nói hầu hết nhân viên không ác ý, chỉ thiếu thời gian, công việc ngày càng nhiều, hạn chót gay gắt hơn. AI là “chất xúc tác” tuyệt vời cho đổi mới, không nên cấm hoàn toàn. “Quan trọng là tổ chức cần có chiến lược bảo mật vững chắc, đồng thời cho phép nhân viên dùng AI hiệu quả,” Arora giải thích. “Cấm tuyệt đối chỉ khiến AI bị đẩy vào hoạt động ngầm, càng nguy hiểm hơn.”

- Đề xuất một cơ chế quản trị AI tập trung. “Giống như các phương pháp quản trị IT khác, AI cần quản trị tập trung để kiểm soát tình trạng tràn lan của ứng dụng shadow AI,” Arora gợi ý. Ông đã thấy nhiều đơn vị dùng công cụ AI SaaS “không qua bất kỳ đánh giá rủi ro hoặc tuân thủ nào.” Thiết lập giám sát nhất quán giúp ngăn ứng dụng chưa được duyệt âm thầm rò rỉ dữ liệu nhạy cảm.

- Liên tục tinh chỉnh khâu phát hiện, giám sát và quản lý shadow AI. Khó khăn lớn nhất là tìm ứng dụng ẩn. Arora nói, để phát hiện cần theo dõi lưu lượng mạng, phân tích luồng dữ liệu, quản lý tài sản phần mềm, yêu cầu mua sắm và thậm chí kiểm toán thủ công.

- Luôn cân bằng linh hoạt và bảo mật. Không ai muốn kìm hãm sáng tạo. “Cung cấp lựa chọn AI an toàn giúp nhân viên không muốn lén lút. Bạn không thể giết AI, nhưng có thể định hướng nó an toàn,” Arora kết luận.

Bắt đầu với 7 bước xây dựng chiến lược quản trị shadow AI

Arora và Golan khuyến nghị khách hàng phát hiện tình trạng shadow AI lan rộng nên tuân theo 7 nguyên tắc sau:

- Thực hiện kiểm toán shadow AI chính thức. Thiết lập một đường cơ sở bằng kiểm toán AI toàn diện. Sử dụng phân tích proxy, giám sát mạng, kiểm kê phần mềm để tìm mọi AI sử dụng trái phép.

- Lập “Office of Responsible AI.” Tập trung hoạch định chính sách, rà soát nhà cung cấp và đánh giá rủi ro giữa IT, an ninh, pháp lý và tuân thủ. Arora thấy cách này phát huy tác dụng ở khách hàng của ông. Văn phòng này cũng cần thiết lập khung quản trị AI và đào tạo nhân viên về nguy cơ rò rỉ dữ liệu. Danh mục AI được phê duyệt cùng quản lý dữ liệu tốt sẽ hướng nhân viên đến giải pháp an toàn, có kiểm soát.

- Triển khai kiểm soát bảo mật biết AI. Các công cụ truyền thống bỏ sót khai thác dựa trên văn bản. Sử dụng DLP dành cho AI, giám sát theo thời gian thực và tự động đánh dấu các prompt đáng ngờ.

- Xây dựng danh mục và kho AI tập trung. Danh sách đã được kiểm duyệt sẽ giảm sức hút của các dịch vụ ngẫu hứng, và nếu IT và an ninh chủ động cập nhật, động cơ tạo shadow AI sẽ giảm. Mấu chốt là cảnh giác, đáp ứng nhu cầu AI tiên tiến an toàn của người dùng.

- Thúc đẩy huấn luyện nhân viên với ví dụ về tác hại của shadow AI. “Chính sách vô dụng nếu nhân viên không hiểu,” Arora nói. Cần giáo dục mọi người về an toàn AI và rủi ro lộ dữ liệu.

- Tích hợp với quy trình quản trị, rủi ro và tuân thủ. Arora và Golan nhấn mạnh quản trị AI phải liên kết với quy trình GRC, đặc biệt quan trọng cho lĩnh vực có quy định.

- Ý thức rằng lệnh cấm hoàn toàn sẽ thất bại, cần cung cấp giải pháp AI hợp pháp nhanh chóng. Golan nói lệnh cấm bao trùm không bao giờ có hiệu quả, lại dẫn đến thêm nhiều shadow AI. Arora khuyến khích khách hàng dùng các lựa chọn AI an toàn (ví dụ Microsoft 365 Copilot, ChatGPT Enterprise) với chính sách sử dụng có trách nhiệm.

Cách khai thác lợi thế của AI một cách bảo mật

Bằng việc kết hợp chiến lược quản trị AI tập trung, huấn luyện người dùng và giám sát chủ động, tổ chức có thể tận dụng AI tạo sinh mà không hy sinh yếu tố tuân thủ hay bảo mật. Thông điệp cuối của Arora như sau: “Một giải pháp quản lý tập trung, đi kèm chính sách thống nhất, là chìa khóa. Bạn cho phép đổi mới nhưng vẫn bảo vệ dữ liệu doanh nghiệp, tức vừa được lợi cả đôi đường.” Shadow AI sẽ còn tồn tại. Thay vì cấm, những lãnh đạo nhạy bén chú trọng đẩy mạnh năng suất an toàn, để nhân viên khai thác sức mạnh chuyển đổi của AI theo cách có kiểm soát.