Llama-3.1-Nemotron-Ultra-253B-v1, là một tham số 253 tỷ dày đặc được thiết kế để hỗ trợ suy luận nâng cao, hướng dẫn theo dõi và quy trình làm việc của trợ lý AI.

Lần đầu tiên nó được đề cập tại Hội nghị công nghệ GPU (GTC) thường niên của Nvidia vào tháng 3.

Bản phát hành phản ánh sự tập trung liên tục của Nvidia vào việc tối ưu hóa hiệu suất thông qua đổi mới kiến trúc và đào tạo sau đào tạo có mục tiêu.

Được công bố vào đêm qua, ngày 7 tháng 4 năm 2025, mã mô hình hiện đã có sẵn công khai trên Hugging Face , với trọng số mở và dữ liệu sau đào tạo. Nó được thiết kế để hoạt động hiệu quả ở cả chế độ “lý luận bật” và “lý luận tắt”, cho phép các nhà phát triển chuyển đổi giữa các tác vụ lý luận phức tạp cao và các đầu ra đơn giản hơn dựa trên lời nhắc của hệ thống.

Được thiết kế để suy luận hiệu quả

Llama-3.1-Nemotron-Ultra-253B được xây dựng dựa trên công trình trước đây của Nvidia về phát triển LLM tối ưu hóa suy luận. Kiến trúc của nó—được tùy chỉnh thông qua quy trình Tìm kiếm kiến trúc thần kinh (NAS)—giới thiệu các biến thể cấu trúc như các lớp chú ý bị bỏ qua, mạng truyền thẳng hợp nhất (FFN) và tỷ lệ nén FFN thay đổi.

Việc cải tiến kiến trúc này giúp giảm dung lượng bộ nhớ và nhu cầu tính toán mà không ảnh hưởng nghiêm trọng đến chất lượng đầu ra, cho phép triển khai trên một nút GPU 8x H100 duy nhất.

Theo Nvidia, kết quả là một mô hình cung cấp hiệu suất mạnh mẽ trong khi tiết kiệm chi phí hơn khi triển khai trong môi trường trung tâm dữ liệu. Khả năng tương thích phần cứng bổ sung bao gồm hỗ trợ cho vi kiến trúc B100 và Hopper của Nvidia, với cấu hình được xác thực ở cả chế độ chính xác BF16 và FP8.

Đào tạo sau khi lập luận và sắp xếp

Nvidia đã cải thiện mô hình cơ sở thông qua một đường ống đào tạo sau nhiều giai đoạn. Điều này bao gồm việc tinh chỉnh có giám sát trên các miền như toán học, tạo mã, trò chuyện và sử dụng công cụ, sau đó là học tăng cường với Tối ưu hóa chính sách tương đối nhóm (GRPO) để tăng cường hơn nữa hiệu suất làm theo hướng dẫn và lý luận.

Mô hình đã trải qua giai đoạn chưng cất kiến thức trên 65 tỷ mã thông báo, sau đó là quá trình đào tạo trước liên tục trên 88 tỷ mã thông báo khác.

Các tập dữ liệu đào tạo bao gồm các nguồn như FineWeb, Buzz-V1.2 và Dolma. Các lời nhắc và phản hồi sau đào tạo được rút ra từ sự kết hợp giữa các tập đoàn công khai và các phương pháp tạo tổng hợp, bao gồm các tập dữ liệu dạy mô hình phân biệt giữa các chế độ lý luận của nó.

Cải thiện hiệu suất trên nhiều miền và điểm chuẩn

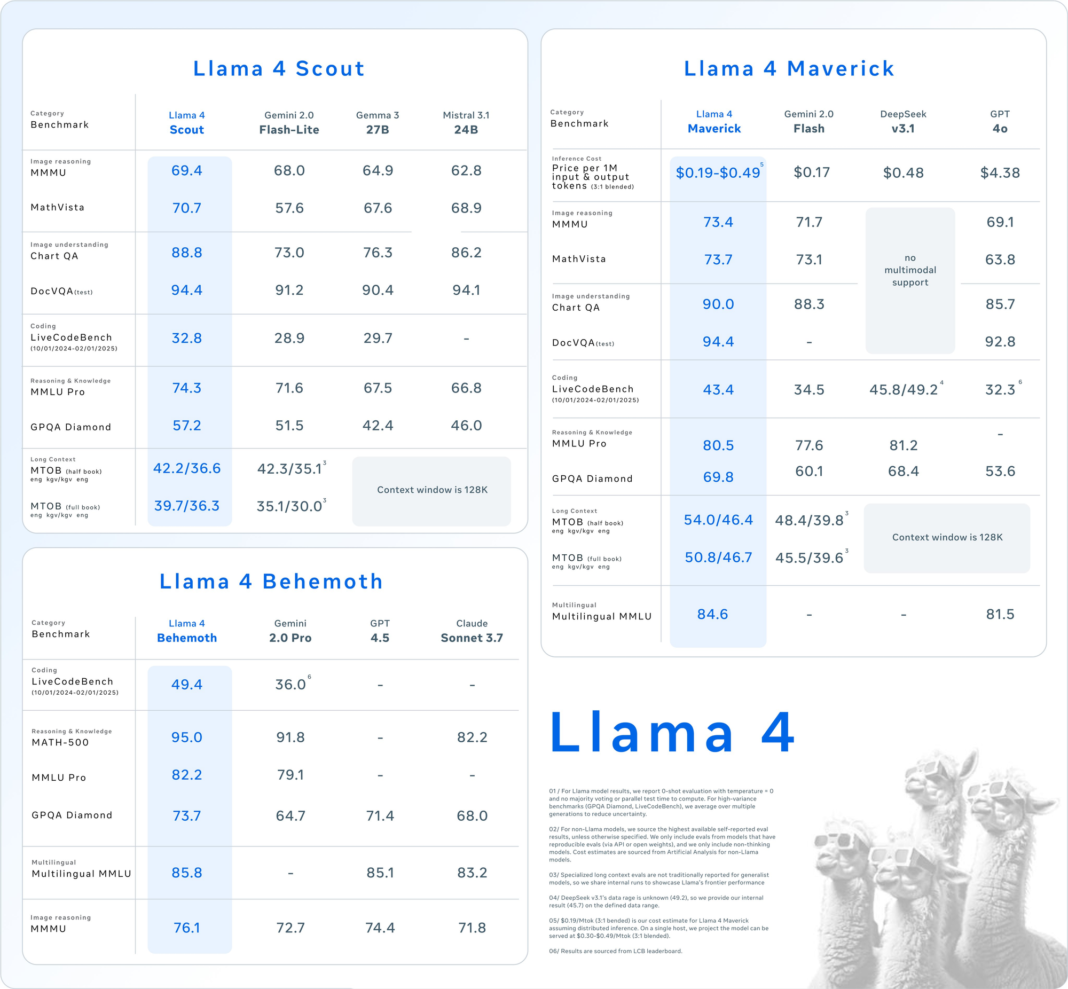

Kết quả đánh giá cho thấy những cải thiện đáng kể khi mô hình hoạt động ở chế độ hỗ trợ lý luận. Ví dụ, trên chuẩn MATH500, hiệu suất tăng từ 80,40% ở chế độ chuẩn lên 97,00% khi hỗ trợ lý luận.

Tương tự như vậy, kết quả trên chuẩn AIME25 tăng từ 16,67% lên 72,50% và điểm LiveCodeBench tăng gấp đôi, từ 29,03% lên 66,31%.

Hiệu suất cũng được quan sát thấy trong các tác vụ dựa trên công cụ như BFCL V2 và thành phần chức năng, cũng như trong trả lời câu hỏi chung (GPQA), trong đó mô hình đạt 76,01% ở chế độ lý luận so với 56,60% khi không có.

Các tiêu chuẩn này được tiến hành với độ dài chuỗi tối đa là 32.000 mã thông báo và mỗi thử nghiệm được lặp lại tối đa 16 lần để đảm bảo độ chính xác.

So với DeepSeek R1, một mô hình MoE hiện đại với tổng cộng 671 tỷ tham số , Llama-3.1-Nemotron-Ultra-253B cho thấy kết quả cạnh tranh mặc dù số lượng tham số ít hơn một nửa (cài đặt mô hình) — vượt trội trong các tác vụ như GPQA (76,01 so với 71,5), theo dõi hướng dẫn IFEval (89,45 so với 83,3) và tác vụ mã hóa LiveCodeBench (66,31 so với 65,9).

Trong khi đó, DeepSeek R1 nắm giữ lợi thế rõ ràng trong một số đánh giá toán học, đặc biệt là AIME25 (79,8 so với 72,50) và nhỉnh hơn MATH500 (97,3 so với 97,00).

Những kết quả này cho thấy rằng mặc dù là một mô hình dày đặc, nhưng sản phẩm của Nvidia vẫn ngang bằng hoặc vượt trội hơn các giải pháp thay thế của MoE về mặt lý luận và nhiệm vụ căn chỉnh hướng dẫn chung, trong khi vẫn chậm hơn một chút về các hạng mục thiên về toán học.

Sử dụng và tích hợp

Mô hình này tương thích với thư viện Hugging Face Transformers (khuyến nghị phiên bản 4.48.3) và hỗ trợ chuỗi đầu vào và đầu ra lên tới 128.000 mã thông báo.

Các nhà phát triển có thể kiểm soát hành vi lý luận thông qua lời nhắc của hệ thống và lựa chọn chiến lược giải mã dựa trên yêu cầu của nhiệm vụ.

Đối với các tác vụ lý luận, Nvidia khuyến nghị sử dụng lấy mẫu nhiệt độ (0,6) với giá trị p hàng đầu là 0,95. Đối với đầu ra xác định, giải mã tham lam được ưu tiên.

Llama-3.1-Nemotron-Ultra-253B hỗ trợ các ứng dụng đa ngôn ngữ, có khả năng hỗ trợ tiếng Anh và một số ngôn ngữ khác, bao gồm tiếng Đức, tiếng Pháp, tiếng Ý, tiếng Bồ Đào Nha, tiếng Hindi, tiếng Tây Ban Nha và tiếng Thái.

Nó cũng phù hợp với các trường hợp sử dụng LLM phổ biến như phát triển chatbot, quy trình làm việc của tác nhân AI, tạo ra dữ liệu tăng cường truy xuất (RAG) và tạo mã.

Được cấp phép sử dụng cho mục đích thương mại

Được phát hành theo Giấy phép mô hình mở Nvidia và được quản lý bởi Thỏa thuận cấp phép cộng đồng Llama 3.1, mô hình này đã sẵn sàng cho mục đích thương mại.

Nvidia đã nhấn mạnh tầm quan trọng của việc phát triển AI có trách nhiệm, khuyến khích các nhóm đánh giá mức độ liên kết, an toàn và độ lệch của mô hình cho các trường hợp sử dụng cụ thể của họ.

Oleksii Kuchaiev, Giám đốc Đào tạo mô hình AI tại Nvidia, đã chia sẻ thông báo trên X , nêu rằng nhóm rất vui mừng khi chia sẻ bản phát hành mở, mô tả đây là mô hình 253B dày đặc được thiết kế với khả năng suy luận BẬT/TẮT và được phát hành với trọng số và dữ liệu mở.